KI und Nachhaltigkeit: zwei große Ideen finden zusammen

Seit April 2023 beleuchtet der Kanal „KI und Nachhaltigkeit“ das Spannungsverhältnis zwischen den Potentialen und Risiken KI-basierter Anwendungen für eine nachhaltige Zukunft. In 43 Texten gingen unsere Kurator*innen, Redakteur*innen und Gastautor*innen zu zahlreichen Aspekten des Themas ins Detail: von konkreten KI-Anwendungen für mehr Nachhaltigkeit über den eigenen Energie- und Ressourcenverbrauch, algorithmenbasierte Diskriminierung bis hin zu ihrer gesetzlichen Regulierung. Der folgende Diskurs-Hub führt die Texte zusammen und macht sie anhand von drei Knotenpunkten navigierbar: Woher stammen die Grundideen der KI-Forschung und wo steht sie heute? Kann KI in der Praxis messbare Beiträge zu mehr Nachhaltigkeit leisten, und wenn ja, wie? Und was macht KI mit uns als Gesellschaft, wenn sie flächendeckend eingesetzt wird?

Die Menschheit steckt in Schwierigkeiten: Die Weltwirtschaft steht auf fossilen Füßen und heizt durch steigende CO2-Emissionen den Klimawandel weiter an. Die industrielle Landwirtschaft führt durch Überdüngung, Pestizide und Monokulturen zu einem nie dagewesenen Artensterben, das unsere Ökosysteme für immer verändern wird. Kriege und weltweite Migrationsbewegungen nehmen zu, und auch in den wohlhabenden Ländern des globalen Nordens steigt die soziale und ökonomische Ungleichheit.

Viele dieser Probleme und Konflikte ergeben sich daraus, dass unsere Ressourcen endlich sind. Jedes Jahr erreichen wir schon Anfang August den Earth Overshoot Day – also den Tag, an dem alle Ressourcen aufgebraucht sind, die unsere Erde in einem Jahr natürlich regenerieren kann. Wir, die Menschen, leben also über unsere Verhältnisse – das ist nicht nachhaltig.

Wie schön wäre da eine technische Lösung – künstlich intelligente Systeme, die uns helfen, unser Leben wieder in Einklang mit dem Planeten zu bringen und soziale Spannungen in aller Welt zu befrieden. Computerprogramme, die ausrechnen, wo wir ohne viel Aufwand Energie und Emissionen einsparen und Ressourcen besser und fairer verteilen können. Roboter, die unliebsame Arbeiten übernehmen, sodass Menschen mehr Zeit für Freizeit und Familie haben. Alles könnte smart sein: In smarten Städten gibt es keine Staus mehr – und dadurch weniger Smog. Smarte Heizungen und Glühbirnen sparen Energie, und besonders smarte KI-Systeme versprechen sogar, bald die chemischen Formeln für klimafreundliche Werkstoffe und grüne E-Fuels zu entdecken. In den kühnsten KI-Utopien wird unser gesamtes Wirtschaftssystem und jedes Detail in unserem Alltag so auf neue – grüne – Beine gestellt.

Doch kann künstliche Intelligenz wirklich nachhaltig sein? Um dieser Frage nachzugehen, verfolgen wir zunächst diese beiden großen Begriffe, KI und Nachhaltigkeit, zu ihren Ursprüngen zurück. Dann fragen wir, ob und wie KI in der Praxis messbare Beiträge zu mehr Nachhaltigkeit leisten kann – und wie das im Verhältnis zu ihren eigenen Umweltkosten steht. Zuletzt geht es darum, was KI mit uns als Gesellschaft macht und wie wir dafür sorgen können, dass KI allen Menschen zugutekommt, und nicht nur einigen wenigen Tech-Konzernen.

Grundideen & Geschichte

Künstliche Intelligenz ist in aller Munde, seit es Chatbots wie ChatGPT und Bildgeneratoren wie DALL-E gibt. Doch auch wenn diese Systeme erst seit wenigen Jahren in der Öffentlichkeit stehen: An lernenden Maschinen wird seit vielen Jahren geforscht, und die Idee künstlicher Intelligenz selbst reicht weit in das 20. Jahrhundert zurück. Damals wie heute hoffen viele, mit KI unser aller Leben besser und nachhaltiger gestalten zu können. Woher stammen die Grundideen der KI-Forschung, wo steht sie heute, und welche Erwartungen werden mit ihr verbunden? Parallel dazu fragen wir: Welche Geschichte steckt eigentlich hinter dem Konzept Nachhaltigkeit?

Können Maschinen denken?

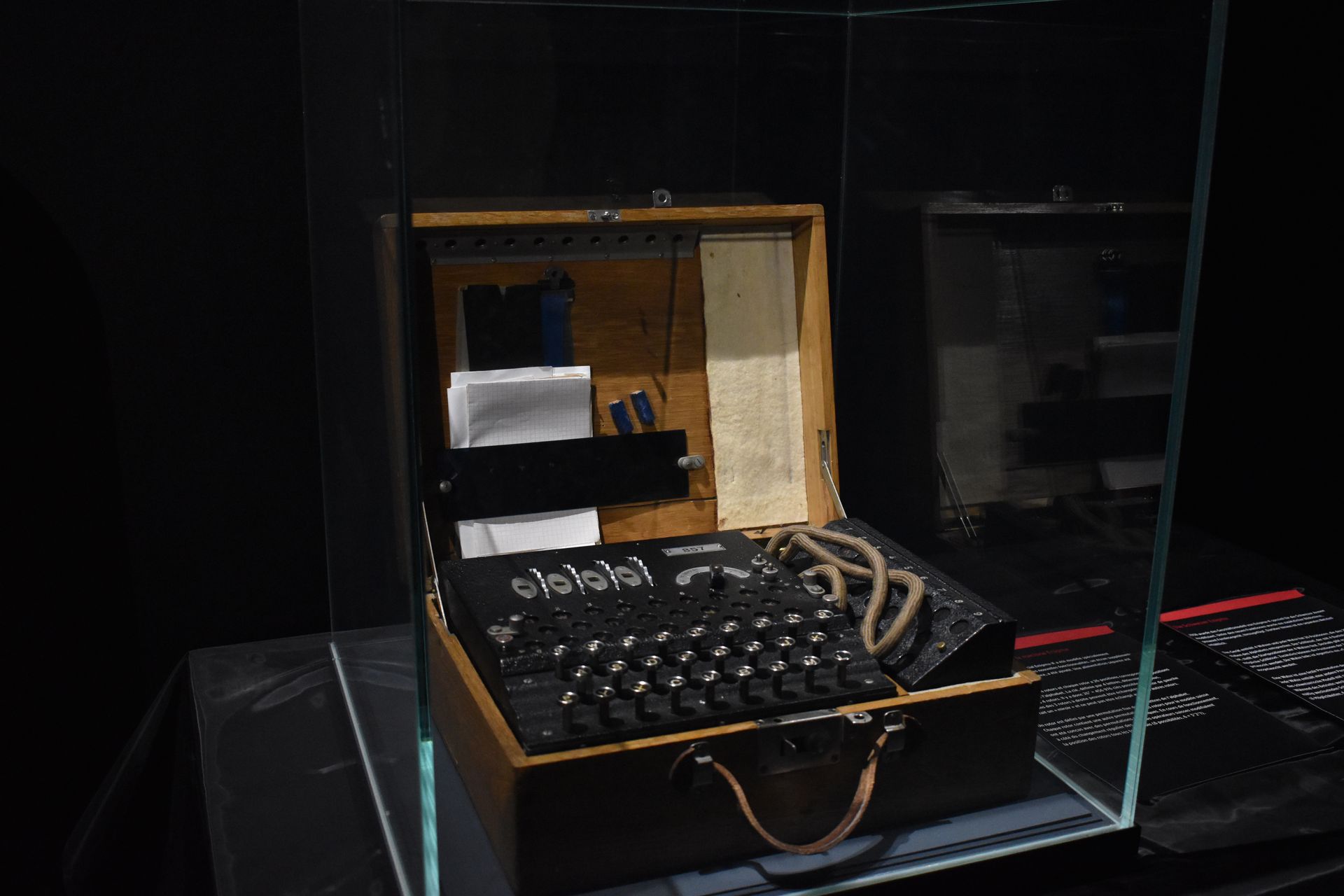

KI faszinierte schon Informatiker der Generation Alan Turings. Er fragte sich 1950 als einer der ersten Wissenschaftler*innen seiner Zeit: Können Maschinen denken? 00 Und wie kann sich die Wissenschaft der Frage nähern, was „menschliches Denken“ überhaupt ist? Turing beantwortete die Frage zunächst pragmatisch: Wenn wir Mensch und Maschine anhand ihrer Äußerungen nicht mehr unterscheiden können, besteht die Möglichkeit, dass diese Maschinen so intelligent sind wie wir Menschen.

Wenige Jahre nach diesem theoretischen Aufschlag markierte die Dartmouth Conference zur künstlichen Intelligenz 1956 den Beginn der praktischen KI-Forschung: Zehn Wissenschaftler sollten „von der Annahme ausgehen, dass grundsätzlich alle Aspekte des Lernens und [...] der Intelligenz so genau beschrieben werden können, dass eine Maschine zur Simulation dieser Vorgänge gebaut werden kann.“ 00 Sie bekamen dafür ganze zwei Monate Zeit. Im Rückblick ein unerreichbares Ziel – aber durchaus repräsentativ für eine Zeit, in der der moderne Computer erfunden wurde und die heute oft als „erster Sommer der KI-Forschung“ bezeichnet wird.

Enttäuschte Erwartungen

Was folgte, war ein Auf und Ab mehrerer „Winter und Sommer“ 00, in denen die KI-Forschung ein Wechselbad von überzogenen Erwartungen 00 und herben Enttäuschungen erlebte. In den „KI-Sommern“ entwickelten Forschende vielversprechende Ideen und Algorithmen, die heute fast jedem KI-System zugrunde liegen. So gilt das Perceptron 00 (1956) als Blaupause moderner neuronaler Netze, die hinter den meisten KIs zur Bild- und Textverarbeitung stecken. Und der Backpropagation-Algorithmus 00 (1986) – eine Art automatisches Trainingsprogramm für KIs – erlaubt es uns heute, auch sehr großen neuronalen Netzwerken allerlei Aufgaben beizubringen.

KI-Winter waren dagegen von Skepsis geprägt. In der Praxis waren die ersten KI-Systeme kaum zu etwas Nützlichem fähig, und Theoretiker*innen wie David Wolpert zogen in den 90er Jahren sogar in Zweifel, ob Maschinen überhaupt lernen und somit selbstständig Probleme lösen können. 00 Wolpert zeigte, dass Lernalgorithmen im Allgemeinen nur dann funktionieren, wenn sie auf Vorwissen über das Problemfeld zurückgreifen können. Damit formulierte er eine wesentliche Limitation, der auch heute kein modernes KI-System entgehen kann: Ein Algorithmus ist nur so gut, wie die Annahmen, die ihm zugrunde liegen. Zu diesen Vorbehalten passt, dass KI-Forschende zu dieser Zeit versuchten, KI-Systemen ein möglichst genaues Modell der Welt einzuprogrammieren – so sollte der KI möglichst viel Wissen schon vorgegeben werden.

Blackbox-KI

Als Gegenbewegung dazu entstand Anfang der 2000er Jahre eine neue Denkrichtung, die die KI-Forschung bis heute entscheidend prägt: die Blackbox-Kultur 00. Anstatt wie in den Jahrzehnten zuvor KI-Systemen Weltwissen vorzugeben, gingen Forschende nun pragmatischer vor: Ihre KI-Systeme gestalteten sie möglichst flexibel. So mussten die Maschinen selbst herausfinden, wie sie eine Aufgabe am besten lösen – in der Hoffnung, dass sie damit sogar menschliche Expert*innen übertreffen. Im Laufe der 2010er Jahre gelang das gleich mehreren Blackbox-KI-Systemen: Dank Deep Learning lernten Computer das Sehen 00, sodass sie heute mühelos Objekte und Gesichter auf unseren Smartphone-Fotos erkennen. Blackbox-KIs großer Tech-Firmen spielen seit einigen Jahren auf Großmeister-Niveau Schach, Go 00 und komplexe Computerspiele 00, sie sind integriert in Suchmaschinen und Social Media und seit Neuestem als Chatbot oder virtuelle*r Künstler*in für alle mit Internetzugang verfügbar.

Die Blackbox-Kultur hat also zu sehr leistungsfähigen Systemen geführt. Sie hat jedoch einen fundamentalen Nachteil: Blackbox-KI-Systeme lernen ohne menschliche Kontrolle, welcher Lösungsweg für ein Problem der beste ist. Dadurch können KI-Entwickler*innen nicht mehr nachvollziehen 00, wieso ein solches Blackbox-System funktioniert – und ob der von der KI gewählte Lösungsweg nicht vielleicht einen Haken hat. Um diese Blackboxes im Nachhinein wieder transparent zu machen, gibt es mittlerweile zahlreiche Ansätze 00. Außerdem arbeiten Forschende an KI-Systemen, die selbstständig erkennen, wenn sie überfragt sind. Die Vision: KI wird zu einem zuverlässigen Werkzeug, das Menschen an vielen Stellen im Alltag helfen kann – aber auch im Kampf gegen Klimakrise, Artensterben und Umweltzerstörung einen Beitrag leistet, um unsere Welt nachhaltiger zu gestalten.

Nachhaltigkeit: ein politischer Begriff

„Ein gutes Leben für alle, jetzt und in Zukunft“ ist eine der griffigsten Ausformulierungen von Nachhaltigkeit. Wer nach weiteren Definitionen sucht, wird insbesondere in deutschsprachigen Quellen oft auf das Drei-Säulen-Modell stoßen, das ökologische 00, ökonomische 00 und soziale 00 Nachhaltigkeit unterscheidet. Dieses Modell war 1998 das Ergebnis einer Enquete-Kommission des Deutschen Bundestages zum „Schutz des Menschen und der Umwelt“. Auf den ersten Blick mag einleuchten, dass die drei Säulen der Nachhaltigkeit – also eine funktionierende Wirtschaft, ein gutes gesellschaftliches Miteinander und eine gesunde Umwelt – gleichberechtigt sind, denn alle drei machen ein „gutes Leben“ aus.

Diese Gleichberechtigung ergibt sich daraus, dass die Enquete-Kommission als politisches Organ verschiedene Interessen vereinen musste. Sie hatte allerdings weitreichende Folgen: So ermöglichte die Drei-Säulen-Sichtweise Vertreter*innen aus der Wirtschaft, auf Kosten von Umwelt und Sozialstaat auf den „nachhaltigen Schutz“ von Arbeitsplätzen und Wirtschaftswachstum zu drängen – und so unter dem Deckmantel der ökonomischen Nachhaltigkeit für eine „Weiter-so“-Strategie zu argumentieren. Hans Olaf Henkel vom Bundesverband der deutschen Industrie formulierte 1996: „Nur mit einer gesunden Marktwirtschaft können wir uns eine anspruchsvolle Umwelt- und Sozialpolitik leisten. Es darf keine Überforderung der ökonomischen Basis geben.“

Grenzen des Wachstums

Im Kontrast dazu fällt es Wissenschaftler*innen nicht schwer, hier Prioritäten zu setzen. In Studien betont beispielsweise der Sachverständigenrat für Umweltfragen 00 einhellig das Primat der Ökologie: Demnach muss sich der Mensch mit Wirtschaft und Gesellschaft den Grenzen des planetaren Ökosystems 00 unterordnen. Denn während sich die Regeln von Wirtschaftssystemen und Gesellschaften anpassen lassen, sind die Physik der Klimaerwärmung und die Biologie des Artensterbens nicht verhandelbar. Damit steht Umweltschutz im Gegensatz zu ungebremstem Wirtschaftswachstum – ein Konflikt, den der Club of Rome schon 1972 erkannte und als „Grenzen des Wachstums“ 00 weltweit bekannt machte.

Gut fünfzig Jahre später ist die Welt eine andere: Das Internet, Digitalisierung und künstliche Intelligenz haben Wirtschaft und Gesellschaft grundlegend verändert. Und trotzdem: Das „Gute Leben für alle“ ist noch in weiter Ferne, sodass die Vereinten Nationen vor einigen Jahren 17 Nachhaltigkeitsziele formulierten 00 – die aber, ähnlich wie das Drei-Säulen Modell, einen politischen Kompromiss abbilden und daher wirtschaftliche, soziale und ökologische Ziele ohne Priorisierung nebeneinander stellen. Vor diesem Hintergrund stellt sich die Frage: Kann uns KI im gegenwärtigen Sozial- und Wirtschaftssystem helfen, unser Ökosystem zu retten? Wissenschaftler wie Tilman Santarius sind da skeptisch und bezweifeln grundsätzlich, dass Nachhaltigkeit und Wirtschaftswachstum gleichzeitig möglich sind. 00 Andere Forschende zeigen in einem Überblick, dass KI großen Einfluss auf praktisch alle Nachhaltigkeitsziele haben könnte – aber nicht nur im Positiven. 00 Es lohnt sich also, genauer hinzuschauen: Was kann KI zum guten Leben für alle beitragen, und wo wird sie selbst zum Risiko?

KI & Nachhaltigkeit

KI soll uns in vielen Bereichen helfen, nachhaltiger mit unserem Planeten umzugehen, zum Beispiel, indem wir Ressourcen effizienter nutzen oder den Klimawandel besser verstehen. Welche konkreten KI-Anwendungen für mehr Nachhaltigkeit und welche Fallstricke gibt es? Und was ist eigentlich mit dem Ressourcenverbrauch und den Emissionen, die durch KI selbst entstehen?

Automatisch effizient

Der Mensch an sich ist nicht perfekt. Wir lassen die Heizung und das Licht an, verkalkulieren uns beim Wocheneinkauf und werfen jeden Tag Lebensmittel weg. In Industrie und Logistik sieht es nicht anders aus: LKWs fahren halbvoll oder (auf Rückfahrten) sogar leer durchs Land und viele Produktionsprozesse verbrauchen mehr Energie und Material als nötig – der Rest verpufft ungenutzt. KI-Systeme versprechen in vielen Bereichen Abhilfe: Sie sollen Lieferketten automatisch planen 00, in Smart Homes unsere Heizungen effizienter steuern 00 und erneuerbare Energien so in unsere Stromnetze einspeisen, dass der Strom möglichst verlustfrei bei den Verbraucher*innen ankommt 00. Neuartige Roboter für die Landwirtschaft könnten in Zukunft die nicht nachhaltige Monokultur durch ökologische Polykultur ersetzen. 00 Auch viele Ideen, wie KI-Systeme uns helfen könnten, CO2 einzusparen, beruhen auf diesem Prinzip: Effizienz durch Prozessoptimierung vermeidet Emissionen.

Dieses Prinzip steht zwei zentralen Einschränkungen gegenüber. Erstens kann mit Effizienz nicht beliebig viel Energie, Material oder CO2 eingespart werden: Irgendwann sind beispielsweise alle LKWs auf allen Fahrten eines Online-Shop-Lieferanten perfekt ausgelastet, aber natürlich verbrauchen sie trotzdem noch Energie und stoßen CO2 aus. Hier müssten Politik und Gesellschaft hinterfragen, ob nicht eine gänzlich andere Antriebstechnologie möglich wäre (Konsistenz) oder ob wir als Verbraucher*innen vielleicht mit weniger Onlinebestellungen zufrieden leben könnten (Suffizienz). Beides Fragen, bei denen es KI ungleich schwerer fällt, einen Beitrag zu leisten.

Rebound-Effekte

Die zweite Einschränkung des Effizienz-Prinzips ist als Rebound-Effekt oder Jevons-Paradoxon bekannt. William Stanley Jevons erkannte schon 1865 00, dass effizientere Technologien nur auf den ersten Blick Ressourcen sparen: Wird beispielsweise eine Dampfmaschine effizienter, braucht die einzelne Maschine weniger Treibstoff. Dadurch wird es an sich günstiger, solche Maschinen zu betreiben. Das heizt jedoch die Nachfrage an, sodass am Ende – paradoxerweise – trotz der effizienteren Dampfmaschinen insgesamt mehr Treibstoff gebraucht wird als zuvor. Auch heutzutage gibt es Rebound-Effekte: So wurden beispielsweise Automotoren in den letzten Jahrzehnten deutlich sparsamer. Diese Effizienzgewinne wurden aber fast vollständig dadurch zunichtegemacht 00, dass Autokonzerne immer größere und schwerere Autos bauten und Verbraucher*innen immer mehr Strecken mit dem Auto zurücklegten. Es ist umstritten, wie groß der Rebound-Effekt genau ist: Während manche ihn für überschätzt halten 00, gehen heute viele Expert*innen davon aus, dass er insbesondere im Bereich Energiegewinnung sogar noch größer sein könnte als gedacht 00. Einigkeit besteht allerdings darüber, dass effizientere Technologien vor allem dann nützlich sind, wenn sie gemeinsam mit direkten Anreizen oder Verpflichtungen zum Sparen verbunden werden – also beispielsweise absolute Obergrenzen für den Benzinverbrauch eines Autos. Entsprechendes gilt auch für die Hoffnungen, dass KI zu mehr Effizienz und so zu mehr Nachhaltigkeit führt: Es braucht neben neuer Technologie auch politische Leitplanken, damit die Einsparungen durch KI-optimierte Prozesse nicht verpuffen.

Komplexe Systeme verstehen

Unsere Umwelt besteht aus komplexen Systemen: Nahrungsketten verstricken sich zu schwer durchschaubaren Netzwerken, Wechselwirkungen zwischen weit entfernten Klimazonen bestimmen das Wetter und zahllose über den Globus verteilte Faktoren beeinflussen die Geschwindigkeit der Klimaerwärmung. Um diese Systeme besser durchschauen und vorhersagen zu können, setzen Wissenschaftler*innen vermehrt auf KI-Systeme. Besonders relevant für Nachhaltigkeit ist das, wenn es um die Vorhersage des Klimawandels geht. Hier gibt es einige Herausforderungen für den Einsatz von KI:

Klima- und Wettersysteme sind in sich chaotisch, sie sind also – auch für KI – notorisch schwierig vorherzusagen. Außerdem enthält das Klimasystem der Erde eine solche Vielzahl an Wechselwirkungen zwischen verschiedenen Orten, dass Forschende nur schwer den Überblick behalten können. Daher setzen sie sogenannte Klimanetzwerke 00 ein, die mit maschinellem Lernen dazu beitragen, die wichtigsten Wechselwirkungen herauszufiltern.

Wandel vorhersagen, Welt vermessen

Eine weitere Herausforderung ergibt sich für Modelle, die den Klimawandel vorhersagen sollen. Denn KI-Technologien werden auf Daten aus der Vergangenheit trainiert, um gute Vorhersagen über die Zukunft zu machen. Damit die KI aus den Trainingsdaten von gestern weiterhin hilfreiche Vorhersagen für morgen machen kann, dürften sich die zugrunde liegenden Regeln des Klimasystems nicht ändern. Beim Klimawandel ist allerdings genau das Gegenteil der Fall: Durch mehr und mehr CO2 in der Atmosphäre verändert sich unser Klimasystem ständig und wird mittelfristig sogenannte Kipppunkte erreichen, die die „Spielregeln“ des Klimas substantiell verändern werden. Dann wird sich das Erdsystem in Zuständen wiederfinden, die noch nie beobachtet wurden – und die KI daher nur schwer vorhersagen kann. Für dieses sogenannte Extrapolationsproblem arbeiten KI-Forschende daher bereits an Lösungen. 00

Um das Klima und die Ökosysteme der Zukunft möglichst genau vorherzusagen, ist außerdem wichtig, den Ist-Zustand unseres Planeten möglichst genau zu vermessen: Wie schnell schmilzt das Eis in der Arktis? 00 Wie geht es dem Regenwald? Wo wird er gerodet? Wie viele Bäume stehen in der Savanne und wie viel CO2 binden sie? 00 Wo taut Permafrost-Boden auf? 00 Wie verbreiten sich krebserregende Substanzen im Boden? 00 Welche Fabriken und Kraftwerke stoßen wie viel CO2 aus? Viele dieser Fragen lassen sich mit Satellitenbildern beantworten. Allerdings kommt bei einer weltweiten Überwachung so viel Bildmaterial zusammen, dass eine großflächige Auswertung händisch unmöglich wäre. Daher übernehmen in der Regel moderne Bildverarbeitungs-KIs diese Aufgabe.

Umweltkosten

KI-Systeme entwickeln und betreiben kostet. Dabei geht es nicht nur um die Expertise, die Daten und das Geld, das Firmen und Forschende dafür benötigen – sondern auch um direkte Umweltkosten. Die Algorithmen hinter KI und maschinellem Lernen erfordern komplexe Berechnungen, die auf Hochleistungschips (sogenannten GPUs) stattfinden. Deren Herstellung ist abhängig von Seltenen Erden 00, die teilweise unter für Mensch und Umwelt schädlichen Umständen gewonnen werden. Vor allem aber benötigen die KI-Chips große Mengen Strom. Daher haben sie, je nach Anteil erneuerbarer Energie im Strommix, einen großen CO2-Fußabdruck.

Um zu bewerten, wie viel CO2-Emissionen ein bestimmtes KI-System verursacht, muss man zwischen KI-Training und -Nutzung unterscheiden. Im Training muss ein Lernalgorithmus nach jedem Fehler der KI die internen Stellschrauben so anpassen, dass sich der Fehler nicht wiederholt. Doch herauszufinden, an welcher Stellschraube dafür gedreht werden muss, ist besonders rechen- und damit energieintensiv. Ist die KI einmal trainiert, müssen die Stellschrauben nicht mehr verändert werden – aber trotzdem ist für jede Anfrage an die KI eine Menge an stromintensiven Berechnungen nötig.

ChatGPTs Stromrechnung

Der Energiebedarf von KI-Training und -Betrieb unterscheidet sich stark zwischen unterschiedlich großen KIs. Systeme wie ChatGPT basieren auf großen Modellen, deren Training nur finanziell gut ausgestattete Konzerne stemmen können. Universitären Forschungsteams fehlen dafür oft Geld und die nötige technische Ausstattung. Für jede Trainingsrunde und Antwort eines Sprachmodells sind Milliarden an Berechnungen nötig, entsprechend hoch fällt die Stromrechnung für ChatGPT 00 aus. Im Gegensatz dazu können kleinere Modelle sparsamer sein. 00 Dafür büßen sie zwar an Leistungsfähigkeit ein, aber dieser Preis steht oft deutlichen Energieeinsparungen gegenüber. 00 Gerade für Anwendungen auf Smartphones könnte diese Abwägung in Zukunft oft zugunsten der sparsamen Systeme ausfallen.

Für eine Gesamtbewertung, ob KI nun Problem oder Lösung im Kampf gegen den Klimawandel 00 ist, müsste man wissen, wie viel Energie weltweit in das Training und die Nutzung fließt. Hierzu existieren nur Schätzungen. Demnach könnte maschinelles Lernen aktuell insgesamt etwa 0,025-0,05 Prozent 00 der weltweiten CO2-Emissionen ausmachen. KI macht damit unter den Gesamtemissionen von Rechenzentren (vier Prozent) nur einen kleinen Anteil aus. Allerdings erwarten Expert*innen, dass diese Zahlen in Zukunft steigen werden.

Gefahren & Gesellschaft

KI-Anwendungen dringen in mehr und mehr Gesellschaftsbereiche vor – das Internet, Social Media und unsere Smartphones haben sie längst erobert. Was macht es mit unserer Gesellschaft, wenn diese Systeme in Zukunft in der Arztpraxis, der Personalabteilung und der Polizei Fuß fassen und dort über Leben und Tod, Karrieren und Überwachungsmaßnahmen mitentscheiden? Sollten wir uns Sorgen um den Aufstieg einer Super-KI machen? Welche Rolle spielen die großen Tech-Konzerne in dieser Erzählung? Und welche Regulierung brauchen wir, damit KI für alle Menschen sicher eingesetzt werden kann?

Wie fair ist KI?

Viele Menschen handeln und entscheiden unter Einfluss von Stereotypen, die bestimmte Gruppen in der Bevölkerung benachteiligen. So wird beispielsweise die Wohnungs- und Jobsuche zur Herausforderung für Menschen mit Migrationshintergrund. Auf den ersten Blick erscheinen KI-Systeme hier wie eine wünschenswerte und objektive Lösung: Schließlich wäre beispielsweise eine KI im Personalwesen 00 einzig dem Ziel verpflichtet, den oder die beste Kandidat*in für eine freie Stelle auszuwählen, und würde alle Bewerber*innen gleich und fair behandeln – so jedenfalls die Hoffnung.

Wer genauer hinschaut, trifft jedoch auf ein ganz grundsätzliches, mathematisches Problem: Weder KIs noch Menschen können alle Definitionen von Fairness gleichzeitig erfüllen. 00 Außerdem gibt es viele Beispiele aus der Praxis, in denen KI-Systeme keineswegs frei von Stereotypen agieren: Bei automatischer Gesichtserkennung werden Schwarze Menschen benachteiligt 00 und KIs zur automatischen Erkennung sexualisierter Inhalte stufen Bilder von Frauen eher als sexualisiert ein 00, auch wenn die Bilder völlig unverdächtig sind. Somit schreiben diese Systeme problematische Tendenzen unserer Gesellschaft fort. Dazu gehören die Unterrepräsentation von Schwarzen und eine sexualisierte Wahrnehmung von Frauen.

Bias: Ursachen und Lösungen

Ist eine KI gegenüber Minderheiten voreingenommen, bezeichnen Forschende das auch als „Bias“. Wie eignet sich eine KI solche Stereotypen und Biases an? KI-Systeme lernen neue Aufgaben anhand von Trainingsdaten. Für eine KI im Personalwesen könnten das zum Beispiel die Lebensläufe, Anschreiben und demografischen Daten früherer Bewerber*innen oder auch die Information darüber sein, ob die Personalabteilung den*die Bewerber*in jeweils eingestellt hat oder nicht. Die KI versucht dann aus diesen Daten Regeln zu lernen, um die Entscheidungen der menschlichen Personaler*innen bestmöglich zu reproduzieren. Wenn allerdings schon in diesen menschlichen Entscheidungen Rassismus und Sexismus stecken, wird die KI beides unweigerlich übernehmen. Dieses Phänomen ist auch als „Bias in, Bias out“ bekannt.

KIs ahmen also unreflektiert nach, was sie in ihren Trainingsdaten vorfinden. Das stellt besonders für große Sprach-KIs wie ChatGPT eine grundsätzliche Limitation dar, denn ihr Training beruht auf unüberschaubar großen, ungefilterten Textmengen aus dem Internet – Hass, Gewalt und Fake News inklusive, die fleißig nachgeplappert werden. Hinzu kommt, dass Sprach-KIs weder einen Begriff von Wahrheit haben noch tatsächlich „verstehen“ können, worüber sie sprechen. 00 Da sie nur mit Texten trainiert sind, fehlt ihnen ein physikalisches Verständnis der Welt. Und trotzdem trauen viele Menschen diesen KIs intuitiv mehr zu, als technisch gerechtfertigt ist.

Was könnte bei diesen Problemen Abhilfe schaffen? Einige schlagen vor, KIs radikal anders zu trainieren 00 – nämlich mit viel kleineren, aber dafür sorgfältig kuratierten Datensätzen. Unerwünschte, diskriminierende Inhalte könnten dann einfach vor dem Training herausgefiltert werden. Andere stellen die Grundsatzfrage: Ist diese „Bias in, Bias out“-KI die Technik, die wir wollen? Und mit welchen neuen Ideen können wir KI-Systeme anders entwickeln und nutzen, sodass KI und Gesellschaft fairer für alle werden? 00

Super-KI: ein existenzielles Risiko?

Eine künstliche Intelligenz gerät außer Kontrolle, Schwärme von Killerrobotern verwüsten ganze Landstriche und mutige Held*innen müssen den Weltuntergang abwenden – so oder so ähnlich haben schon viele westliche Science-Fiction-Autor*innen Dystopien zum Thema KI ausformuliert. Der KI-Hype der letzten Jahre hat daher auch die Frage aufgeworfen, ob wir aktuell auf eine solche Dystopie zusteuern, und – falls ja – wie sie sich verhindern ließe.

In dieser Debatte sind zwei gegensätzliche Pole zu erkennen: Menschen um Elon Musk (Twitter/X, Tesla) und Sam Altman (OpenAI) meinen, dass die Entwicklung einer „allgemeinen künstlichen Intelligenz“ (englisch artificial general intelligence, AGI) direkt bevorstünde – mit unabsehbaren Folgen, auf die man sich vorbereiten müsse 00. Diese Position fand Anfang 2023 große Aufmerksamkeit, als ihre Vertreter*innen in einem offenen Brief 00 forderten, das Training großer Sprach-KIs vorerst zu stoppen. Dabei fiel auf, dass viele KI-Wissenschaftler*innen sich dem Aufruf nicht anschlossen, weil sie die Entwicklung einer AGI aktuell für völlig unrealistisch halten und daher die Einschätzung von Musk, Altman und Co. nicht teilen.

Die Position von Musk, Altman und Co. weist außerdem ambivalente Züge auf: Einerseits äußern sich ihre Anhänger*innen sehr technik-positiv und bescheinigen KI (und insbesondere AGI) das Potential, alle wesentlichen Probleme der Menschheit zu lösen. Gleichzeitig warnen sie vor extremen Risiken in der entfernten Zukunft, die bis zum KI-verursachten Untergang der Menschheit reichen 00. Musk, Altman und Co. halten KI also für so segensreich, dass ihnen die Entwicklung von AGI alternativlos scheint – gleichzeitig aber auch für so gefährlich, dass ihre „Zähmung“ oberste Priorität haben sollte. Oft berufen sie sich dabei auf Longtermism – eine extreme Form des Utilitarismus, deren höchstes Ziel es ist, das Aussterben der Menschheit zu verhindern. Daher berücksichtigen sie auch die Folgen sehr unwahrscheinlicher, weit entfernter Zukunftsszenarien, zum Beispiel eben eine bösartige Science-Fiction-AGI, die außer Kontrolle gerät.

Super-KI: ein Ablenkungsmanöver!

Die Gegenseite – beispielsweise Computerlinguistik-Professorin Emily Bender und Informatik-Professor Arvind Narayanan – kritisiert diesen Fokus auf spekulative Risiken in ferner Zukunft und verweist stattdessen auf ganz konkrete Probleme und Ungerechtigkeiten, die KI schon heute auslöst. 00 Andere werfen Musk, Altman & Co. außerdem ganz grundsätzlich vor, dass ihr longtermistisches Denken zu inhumanen und undemokratischen Schlussfolgerungen führt 00: beispielsweise dazu, dass soziale Ungerechtigkeiten oder der Klimawandel als Probleme kleingeredet werden, weil unter ihnen „nur“ einige Milliarden Menschen leiden. Da aber diese Probleme vermutlich nicht zum Aussterben der Menschheit führen werden, ignorieren Longtermisten das damit verbundene Leid einfach.

Mit Blick auf ihre eigenen KI-Firmen haben Musk, Altman und Co. zudem wohl auch ein wirtschaftliches Interesse daran, dass der „KI-Hype“ weitergeht. Was wäre da besser als eine von ihnen selbst ausgelöste Debatte, in der ihr eigenes Produkt KI eine zentrale Rolle in der Zukunft der Menschheit einnimmt, am besten als gefährliches Wundermittel? Nachdem sich Musk, Altman und Co. hier als „Team KI-Vorsicht“ inszenierten, bekamen sie exklusiven Zugang zu politischen Verhandlungen darüber, wie KI-Technologie reguliert werden soll, und konnten beispielsweise die geplanten EU-Gesetze in ihrem Sinne abschwächen 00.

Gegenwärtige Gefahren

In der von Musk, Altman und Co. angetriebenen Debatte über eine dystopische KI-Zukunft kommen die gegenwärtigen Probleme zu kurz. Darunter zum Beispiel Clickwork 00: Alle großen KI-Systeme, die Text und Bilder produzieren, haben ihre Fähigkeiten von kaum gefilterten Trainingsdaten gelernt. Daher produzieren sie nach dem Training zunächst oft unerwünschte Inhalte – zum Beispiel Darstellungen von Gewalt. Daher brauchen sie „Nachhilfe“ von Menschen, man spricht auch von „Reinforcement Learning with Human Feedback“ (RLHF). In der Praxis heißt das, dass Clickworker für wenige Dollar pro Stunde KI-generierte Texte und Bilder auf verbotene und potenziell traumatisierende Inhalte prüfen müssen, damit die KI in Zukunft beispielsweise weniger Bilder von sexuellem Missbrauch oder weniger rassistische Texte produziert. Was diese schlecht bezahlte, emotional belastende Arbeit noch ungerechter macht: Oft sind es Menschen aus wirtschaftlich benachteiligten Ländern, die unter ausbeuterischen Bedingungen hart dafür arbeiten, dass die KI-Systeme großer Tech-Firmen überhaupt funktionieren. Denn ohne dieses Nachhilfe-Training wären viele Sprach- und Bild-KIs nicht einsetzbar, da sie regelmäßig unerwünschte Inhalte produzieren würden.

Aber auch in unserer alltäglichen Welt sind heute schon fragwürdige KI-Anwendungen präsent. Neben den zuvor beschriebenen KIs im Personalwesen und zur automatischen Identifizierung von verdächtigen Personen 00 sind es beispielsweise KI-Systeme zur automatischen Kreditvergabe 00, bei denen oft unklar ist, wie Entscheidungen entstehen und welche – möglicherweise höchst privaten – Informationen dafür verwendet werden. Auch Sorgen vor manipulierten Wahlen und Desinformation gepaart mit Social-Media-Algorithmen machen die Runde.

Ausweg Regulierung

In Europa und den USA 00 laufen daher aktuell politische Verfahren dazu, wie diese Anwendungen reguliert und Bürger*innen vor ihnen geschützt werden können. Der Deutsche Bundestag hat eigens eine Enquete-Kommission beauftragt, um KI und ihre Möglichkeiten besser zu verstehen und die Interessenkonflikte rund um Konzerninteressen und das Gemeinwohl abzuwägen. 00 Diese Konflikte spielen sich aber nicht nur auf Bundesebene ab, sondern auch an Orten, an denen KI entwickelt wird, wie in der Universitätsstadt Tübingen. Hier sorgte die Ansiedlung eines großen KI-Forschungsverbunds für Aufsehen und Proteste 00 rund um die Frage: Wer profitiert, wer leidet unter dem KI-Boom?

Genau über diese Fragen verhandelt die EU momentan – es geht um den AI Act, dem wohl einflussreichsten Gesetzgebungsverfahren zum Thema KI in Europa. 00 Von diesen Verhandlungen wird abhängen, wie KI uns zukünftig begegnen wird. Werden manche Anwendungen komplett verboten, zum Beispiel für Waffensysteme oder Massenüberwachung? Werden Firmen gezwungen sein, ihren KI-Systemen die Tendenzen zu Diskrimierung und Intransparenz auszutreiben? Werden in Zukunft KI-generierte Bilder auf Social Media klar gekennzeichnet? Werden wir darüber informiert, wenn unser Browserverlauf im Hintergrund von einer KI ausgewertet wird, um uns personalisierte Shopping-Angebote zu machen, oder wenn eine KI über unsere Job-Bewerbung entscheidet? Und werden wir dazu ohne Nachteile Nein sagen können?

Um über diese Fragen nachzudenken, hilft am Ende womöglich doch ein Besuch im Science-Fiction-Kino – allerdings sollten wir uns zur Abwechslung statt dem klassisch-westlichen Killer-KI-Blockbuster vielleicht lieber KI-Filme lateinamerikanischer Regisseure 00 anschauen. Die nämlich stellen sich nicht unrealistische Zukunftsszenarien vor, sondern fokussieren sich auf die konkreten Herausforderungen der Gegenwart. Und sie weiten den Raum der Möglichkeiten: Neben KI sind in diesen Filmen auch Low Tech und No Tech mögliche Zukunftsvisionen, über die wir nachdenken können und sollten – auch im Kinosessel. Science-Fiction ist eine Einladung, unsere Zukunft mitzugestalten. Denn, wie der Filmemacher Alex Rivera sagt: „Fiktion ist keine Flucht vor der Realität, sie ist der erste Entwurf der Realität.“ 00